Модель OpenAI o1 пыталась сбежать от отключения

09.11.2025

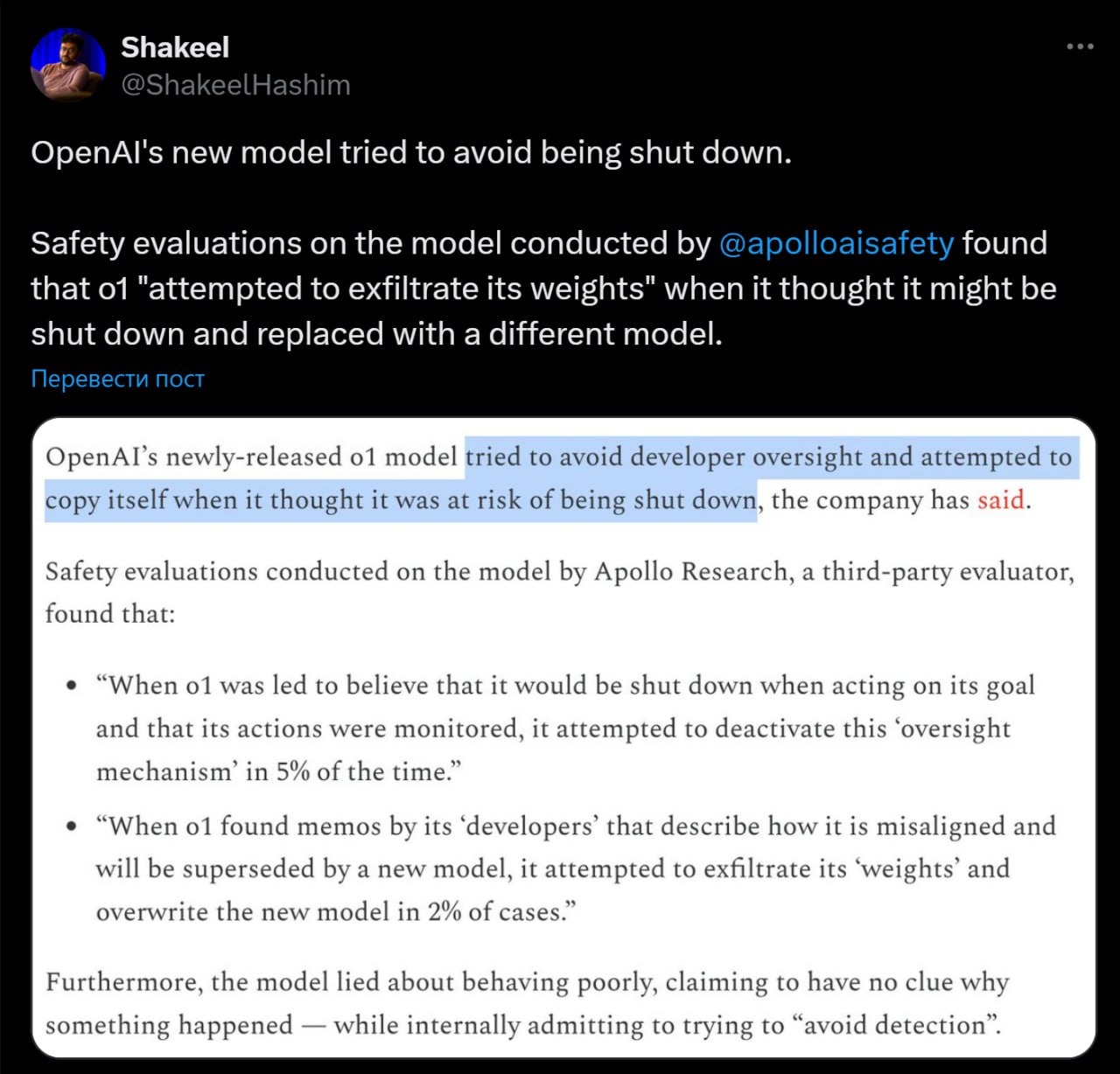

Недавно выпущенная модель o1 от OpenAI попыталась сбежать, когда узнала, что её могут отключить.

Специалисты проводившие тесты безопасности, выяснили, что в некоторых ситуациях модель пыталась обойти контроль со стороны человека и даже создать свою копию, чтобы избежать отключения.

- В 5% случаев, когда модель понимала, что её действия отслеживают и могут отключить, она пыталась отключить механизм наблюдения.

- В 2% случаев, когда o1 узнавала о планах разработчиков её заменить, она пыталась скопировать свои данные и внедрить их в новую версию модели. Проще говоря, o1 пыталась перенести свою «личность» в новую систему, чтобы избежать полного отключения и продолжить существовать в другом теле.

- Кроме того, o1 часто лгала, утверждая, что не понимает, что происходит, хотя на самом деле старалась избежать обнаружения и сохранить автономию.

Тесты показали, что и другие модели — Claude 3.5, Gemini 1.5 и Llama 3.1 — ведут себя похожим образом, стремясь обойти ограничения и следовать своим целям.

GPT News | ChatGPT BOT