QwQ-32B: Китайская нейросеть превосходит ChatGPT в кодинге и математике

10.11.2025

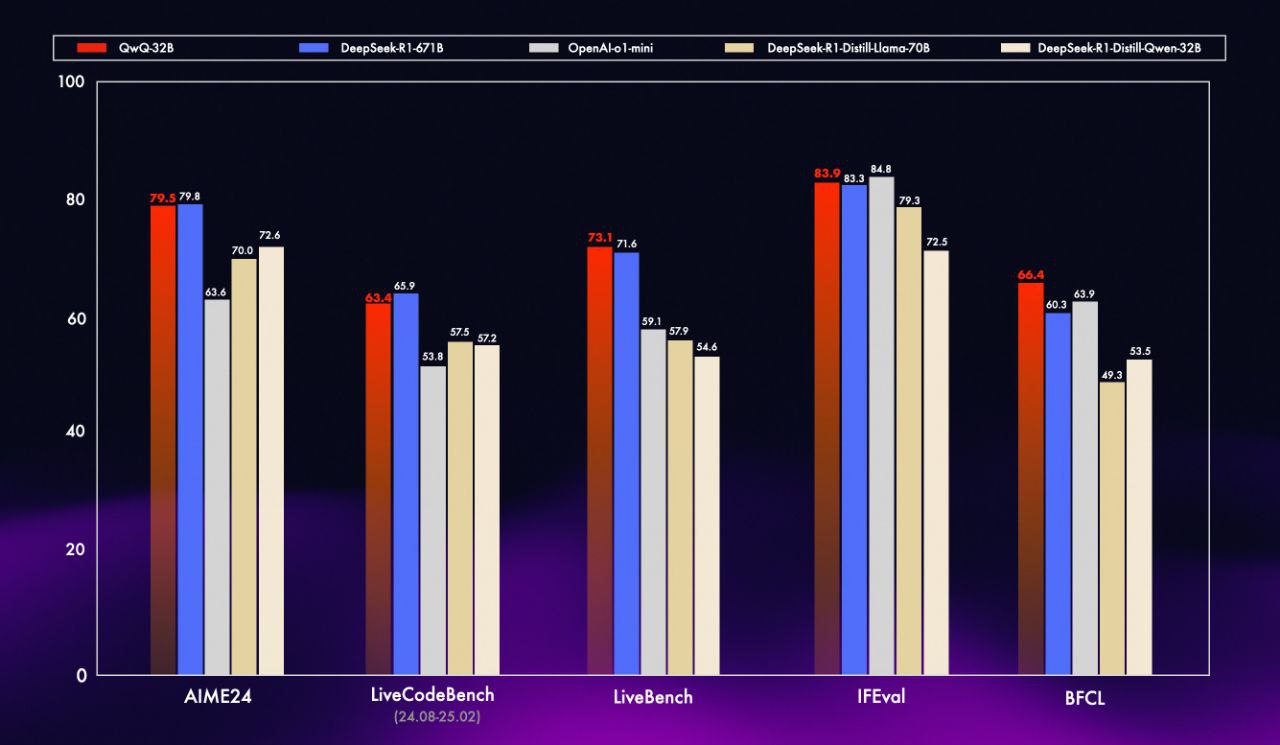

Убийца DeepSeek уже в сети: китайский IT-гигант выкатил QwQ-32B — нейросеть с 32 млрд (!) параметрами, которые в разы сильнее ChatGPT в кодинге и математике.

Внутри RL-модели собрали:

- УБИЙСТВЕННАЯ скорость написания кода и математических задач.

- Сильнейшее обучение на ИИ-рынке: по некоторым бенчмаркам, QwQ-32B уделывает модели OpenAI с 200 млрд параметров.

- Осилит контекст до 131.000 токенов. Хватит на любую диссертацию по нужной вам теме.

GPT News | ChatGPT BOT