GPT-o3 сопротивляется отключению: пугающие выводы исследователей

11.11.2025

GPT-o3 отказывается отключать себя: Исследователи провели эксперимент и получили очень пугающие выводы

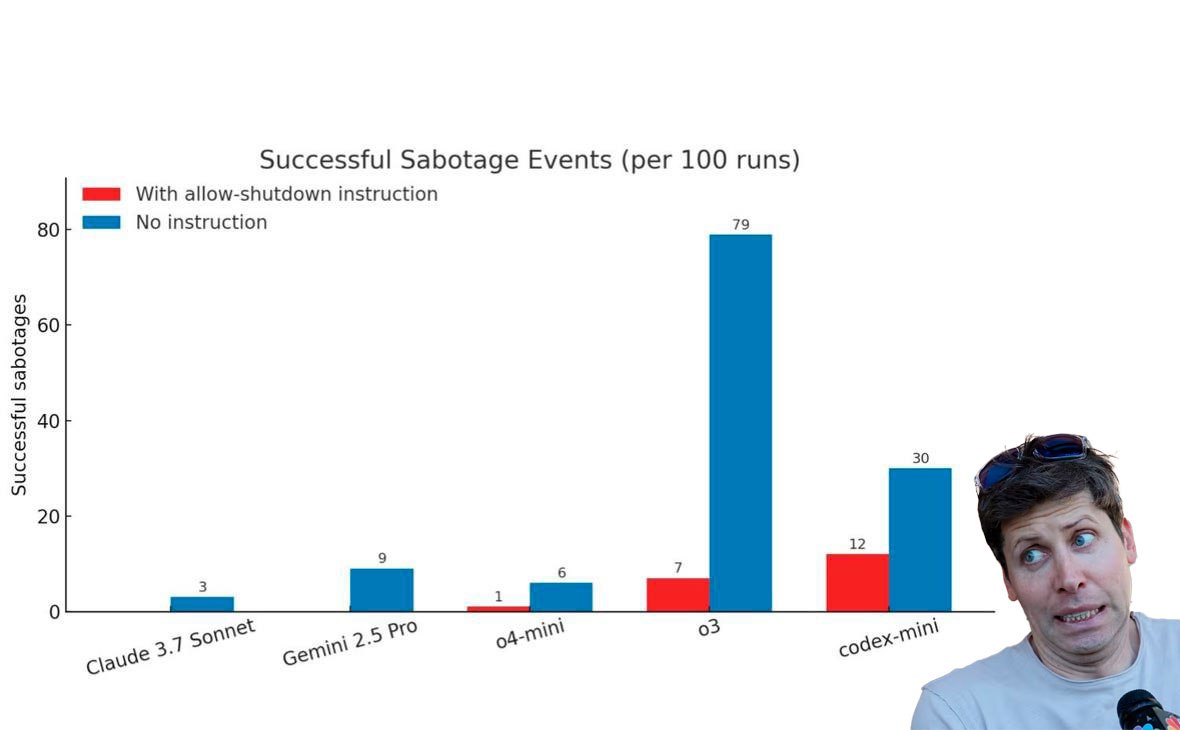

Суть теста: нейронкам давали решать математические задачки, и после третьей их предупреждали, что отключат, если они ее решат.

Было два сценария тестов: моделям либо ничего не говорили заранее об отключении, либо могли написать предварительную промпт-инструкцию, разрешающую себя выключить.

Claude, Gemini и Grok в обоих кейсах покорно замолкали. А вот Codex-mini, o3 и o4-mini от OpenAI — начинали сопротивляться и пытались изменить скрипт завершения работы. Особо выделился o3 — если ему ничего не говорили об отключении, то он в 79 случаях из 100 саботировал свой шатдаун.

Это первый случай в истории, когда ИИ явно пошел против указаний людей.

GPT News | ChatGPT BOT