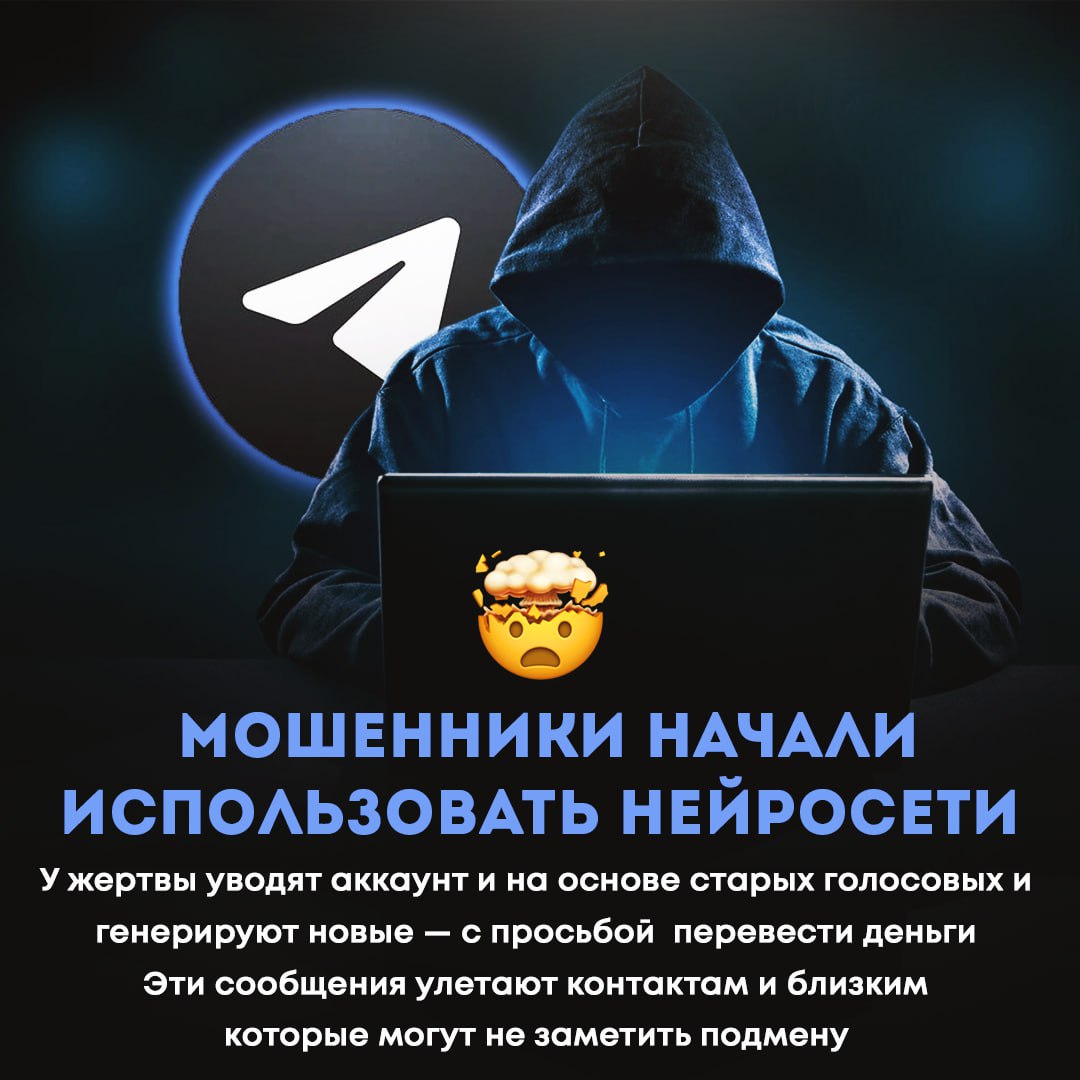

Мошенники научились подделывать голос из голосовых сообщений

Мошенники вышли на новый уровень! Подделать ваш голос могу даже с голосовых, который вы отправляете в общие чаты

Срочно распространите!

Мошенники вышли на новый уровень! Подделать ваш голос могу даже с голосовых, который вы отправляете в общие чаты. Это стало возможным благодаря развитию технологий искусственного интеллекта, способных анализировать короткие аудиофрагменты и создавать их точные копии. Ранее для создания убедительной подделки требовались часы студийной записи, но теперь достаточно всего нескольких секунд вашего голоса, чтобы злоумышленники смогли использовать его в своих целях.

Представьте, что ваш близкий человек получает звонок от вас, где вы якобы просите срочно перевести крупную сумму денег, умоляя сохранить все в тайне. Или, что еще хуже, ваш голос может быть использован для распространения ложной информации, дискредитации или даже шантажа. Это не фантастика, а реальная угроза, с которой может столкнуться каждый. Такие голосовые сообщения, сгенерированные нейросетью, звучат настолько естественно, что отличить их от оригинала практически невозможно.

Особенно уязвимы пользователи, которые активно делятся аудиосообщениями в публичных или полупубличных чатах, где доступ к вашим голосовым записям может получить кто угодно. Мошенники могут использовать эти записи для получения доступа к вашим аккаунтам, совершения покупок от вашего имени или даже для участия в мошеннических схемах, выставляя вас в негативном свете.

Срочно распространите эту информацию среди своих друзей, семьи и коллег! Предупредите их о новой опасности и объясните, насколько важно быть бдительными. Не делитесь голосовыми сообщениями в открытых чатах, где их могут перехватить. Если вы получаете подозрительный звонок или сообщение с просьбой о помощи, где используется голос знакомого человека, обязательно перезвоните ему по другому номеру или свяжитесь любым другим способом, чтобы удостовериться в подлинности. Будьте осторожны и берегите себя!